직선의 벡터방정식

- 좌표평면에 y = mx가 있을때, 임의의점 (x, y)를 벡터로 표현해주기 위해서는

y = mx 와 평행한 벡터를 잡고 스칼라배를 해주면 y = mx의 모든 점이 표현 가능합니다.

1. y = mx는 (1, m) 이라는 점을 지납니다.

2. 그렇다면 (1, m) 이라는 벡터값은 y = mx를 지나는 벡터입니다.

3. 여기서 y = mx를 지나는 임의의 점 (x, y)의 벡터는 (1, m)의 벡터에 스칼라배를 해주면 표현이 가능합니다.

4. (1, m) = V → (x, y) = tV

- 벡터 방정식의 장점: 관계식 필요없이 어떠한 값만 대입했을때 값에 해당하는 좌표를 얻을 수 있습니다.

- 다른 표현법

1. y = mx라는 직선 위에 (2, 2m/3) 이라는 점이 있는지 체크해보기

2. x = tV → 여기서, V = (1, m)

3. t에 2를 넣으면 (2, 2m)이 나오므로 (2, 2m/3) 이라는 점은 y = mx를 지나지 않습니다.

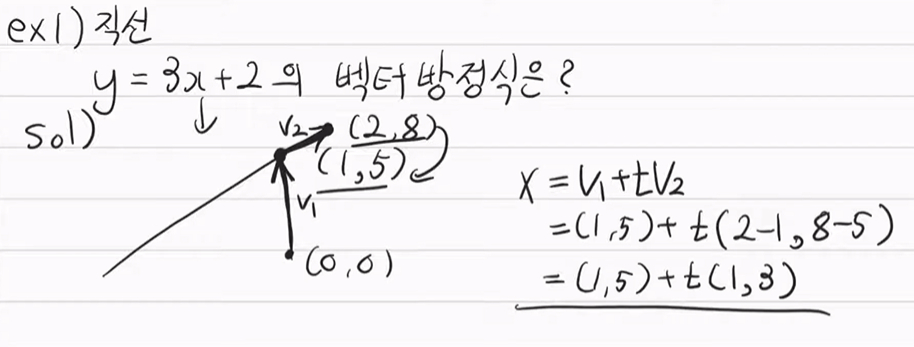

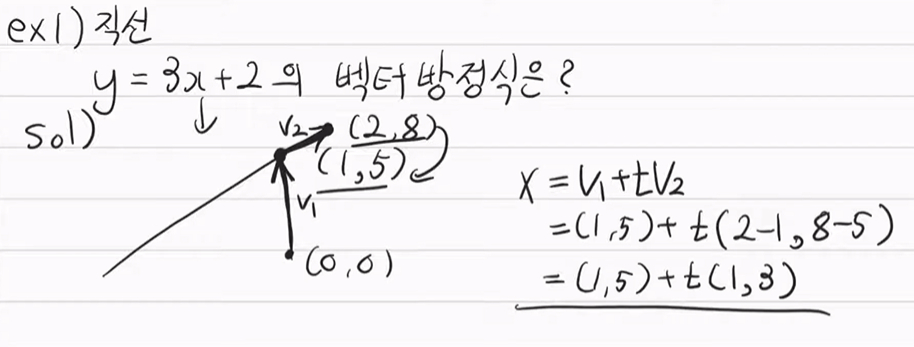

※ y = mx + b 일때, (0, b) = V0

x = V0 + tV1

※ 차원에 상관없이 확장하기 쉽다.

평면의 벡터 방정식

- 평면을 표현하기 위해서는 벡터가 2개 필요합니다.

- 좌표 평면상 (3, 2) 라는 좌표가 있고, Standard Unit Vector로 바꾸면, e1 = (1, 0), e2 = (0, 1)

(3, 2) → 3e1 + 2e2 이렇게 됩니다.

여기서, e1 = (1, 0) 이고, e2 = (0, 1) 이기 때문에

두개 벡터에 각각 스칼라배를 취함으로써 좌표 평면 전체를 표현할 수 있습니다.

※ 단, e1과 e2가 평행한 벡터면 평면을 표현할 수 없습니다.

평행하면 방향이 같이 때문에 덧셈이 가능하므로 하나의 벡터로 취급된다.

※ 두 벡터가 독립적이다: 두 벡터가 평행하지 않다.

※ 두 벡터가 종속적이다: 두 벡터가 평행하다.

- 평면 벡터 방정식의 표현

3차원에서 어떠한 평면에 점(a) 하나를 찍고,

원점에서부터 (a) 까지의 벡터를 V1,

그리고 평면을 표현하기 위해서는 두개의 벡터가 필요하므로

평면 위에 임의의 점을 2개 찍은후 (a)를 기준으로 벡터를 생성합니다. V2, V3

※ 여기서 평면의 임의의점 X는

X = V1 + t0 x V2 + t1 x V3 가 됩니다.

예제