TN, FN, FP, TN ?

Precision (정밀도), Recall (재현율)

- 한국어로 정밀도라고 부릅니다.

- Model이 찾은 모든 객체 중 옳게 검출한 비율 입니다. (Model 시점으로 보면 편할거 같다!)

Example)

Model이 5개의 객체를 검출했을때, 옳게 검출한 개수가 4개면

Precision = 4/5 = 0.8 이 됩니다.

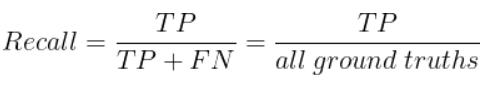

- 한국어로 재현율이라고 부릅니다.

- 실제 모든 객체 중 옳게 검출한 비율 입니다. (정답 시점으로 보면 편할거 같다!)

Example)

검출되어야 하는 객체가 10개라고 했을때, Model이 옳게 검출한 개수가 4개면

Recall = 4/10 = 0.4 가 됩니다.

Precision과 Recall 둘 중 하나만 사용해서 성능을 평가하는건 적절하지 않습니다.

또한 위의 Example을 보면 알 수 있듯이 Precision과 Recall 은 반비례의 관계와 비슷하다는 것을 볼 수 있습니다.

따라서, Precision과 Recall 두 값을 적절하게 이용하여 성능을 평가해야 합니다.

그래서 필요한 것이 Precision-Recall 곡선 및 AP 입니다.

PR 곡선

모델의 confidence에 대한 threshold 값의 변화에 따라 precision과 recall 값들은 달라질 것입니다.

이것을 그래프로 나타낸 것이 바로 PR 곡선입니다.

표 1을 기준으로 예시를 들어보겠습니다.

15개의 객체가 존재하는 이미지를 넣어 얻은 결과값이라고 가정을 한다면,

TP : 옳게 검출

FP : 틀린 검출

- Precision : 7/10 = 0.7

- Recall : 7/15 = 0.47

이제 Threshold 를 각각 다른 값으로 적용을 한 표를 보겠습니다.

위의 표를 보면 Threshold에 따라 Precision과 Recall의 수치가 바뀌는 걸 볼 수 있습니다.

Threshold에 따른Precision과 Recall 값들을 그래프로 표시한것이 PR 곡선 입니다.

AP (Average Precision)

PR 곡선은 어떤 알고리즘의 성능을 전반적으로 파악하기에는 좋으나 서로 다른 두 알고리즘의 성능을 정량적으로 비교하기에는 불편한 점이 있습니다.

그래서 나온 것이 AP 입니다.

보통 계산 전에 PR 곡선을 위의 빨간 점선처럼 살짝 바꿔줍니다. (보간법)

위의 경우 AP는 왼쪽의 큰 사각형의 넓이 + 오른쪽 작은 사각형의 넓이로서

\( AP = 1 x 0.33 + 0.88 x (0.47 - 0.33) = 0.4532 \) 가 됩니다.

mAP (mean Average Precision)

mAP는 Class가 여러개인 경우,

각 Class의 AP를 구한뒤 평균을 내주는 평가 방법입니다.

출처:

'Deep Learning > deep learning' 카테고리의 다른 글

| 06_Loss Function_3_Focal Loss, IoU Loss (0) | 2022.05.11 |

|---|---|

| 06_Loss Function_2_Entropy, Binary, Categorical (0) | 2022.05.04 |

| 06_Loss Function_1_MAE,MSE,RMSE (0) | 2022.05.03 |

| 05_Overfitting, Regularization (0) | 2022.04.18 |

| 04_Max Pooling (0) | 2022.04.18 |